Défaillances de nœuds et disques esclaves dans HDFS

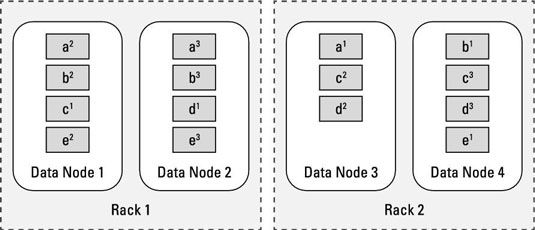

Comme la mort et les impôts, les pannes de disque (et assez de temps donné, même les échecs nœud ou rack), sont inévitables dans le système Hadoop Distributed File (HDFS). Dans l'exemple montré, même si un seul rack devait échouer, le groupe pourrait continuer à fonctionner. Performance souffrirait parce que vous avez perdu la moitié de vos ressources de traitement, mais le système est toujours en ligne et toutes les données est toujours disponible.

Dans un scénario où un disque dur ou un nœud esclave échoue, le serveur central de métadonnées pour les HDFS (appelé NameNode) trouve finalement que les blocs de fichiers stockés sur la ressource échoué ne sont plus disponibles. Par exemple, si l'esclave Node 3 échoue, cela signifierait que les blocs A, C, et D sont underreplicated.

En d'autres termes, trop peu de copies de ces blocs sont disponibles dans HDFS. Lorsque HDFS détecte qu'un bloc est underreplicated, il ordonne une nouvelle copie.

Pour continuer l'exemple, dire que le noeud Esclave 3 revient en ligne après quelques heures. Pendant ce temps, HDFS a veillé à ce que il ya trois exemplaires de tous les blocs de fichiers. Alors maintenant, les blocs A, C, et D ont quatre exemplaires chacun, et sont overreplicated. Comme avec des blocs underreplicated, le serveur central de métadonnées HDFS va trouver sur ce ainsi, et commander un exemplaire de chaque fichier à supprimer.

Un beau résultat de la disponibilité des données est que lorsque des défaillances de disque ne se produisent, il n'y a pas besoin de remplacer immédiatement disques durs défectueux. Cela peut être fait de manière plus efficace à intervalles réguliers.