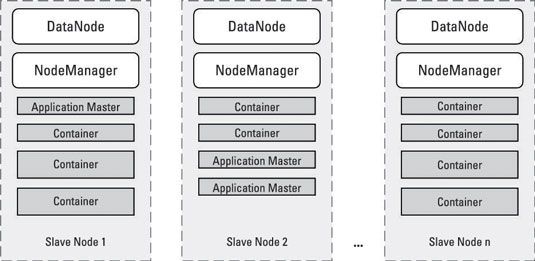

Nœuds esclaves dans les clusters Hadoop

Dans un univers Hadoop, nœuds esclaves sont où les données Hadoop est stockée et où le traitement de données a lieu. Les services suivants permettent nœuds esclaves pour stocker et traiter les données:

NodeManager: Coordonne les ressources pour un nœud et rapports esclave individuelle revenir à la Resource Manager.

ApplicationMaster: Suit la progression de toutes les tâches en cours d'exécution sur le cluster Hadoop pour une application spécifique. Pour chaque demande de client, le gestionnaire de ressources déploie une instance du service de ApplicationMaster dans un conteneur sur un nœud esclave. (Rappelez-vous que tout nœud exécutant le service NodeManager est visible à l'Resource Manager.)

Conteneurs: Une collection de toutes les ressources nécessaires pour exécuter les tâches individuelles pour une application. Quand une application est en cours d'exécution sur le cluster, les horaires Resource Manager les tâches de l'application à exécuter que des services de conteneurs sur les nœuds esclaves de la grappe.

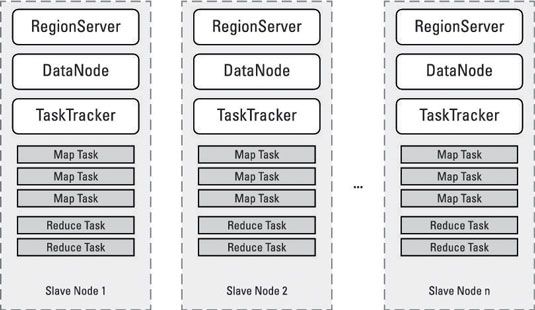

TaskTracker: Gère le plan individuel et de réduire les tâches d'exécution sur un noeud esclave pour Hadoop 1 grappes. Dans Hadoop 2, ce service est obsolète et a été remplacée par les services de fil.

DataNode: Un service de HDFS qui permet à l'NameNode à des blocs de magasins sur le nœud esclave.

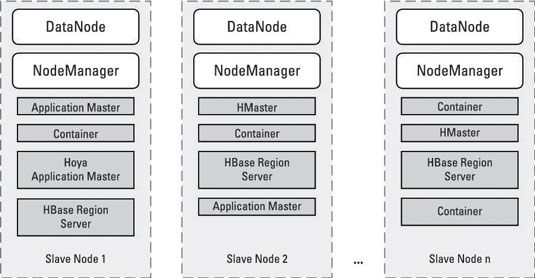

RegionServer: Stocke les données pour le système HBase. Dans Hadoop 2, HBase utilise Hoya, qui permet instances RegionServer être exploités dans des conteneurs.

Ici, chaque nœud esclave est toujours en cours d'exécution d'une instance de DataNode (qui permet HDFS pour stocker et récupérer des blocs de données sur le nœud de l'esclave) et une instance NodeManager (qui permet au Resource Manager pour assigner des tâches d'application pour le noeud esclave pour le traitement). Les processus de conteneur sont des tâches individuelles pour des applications qui sont exécutés sur le cluster.

Chaque application en cours d'exécution a une tâche de ApplicationMaster dédié, qui gère également dans un récipient, et suit l'exécution de toutes les tâches d'exécution sur le cluster jusqu'à ce que l'application est terminée.

Avec Hadoop HBase sur 2, le modèle de conteneur est toujours suivi, comme vous pouvez le voir:

HBase sur Hadoop 2 est initiée par la Hoya demande Maître, qui demande des conteneurs pour les services de HMaster. (Vous avez besoin de services de HMaster multiples pour la redondance.) La Hoya demande Maître demande aussi des ressources pour RegionServers, qui exécutent également dans des conteneurs spéciaux.

La figure suivante montre les services déployés sur des nœuds Hadoop 1 esclaves.

Pour Hadoop 1, chaque noeud esclave est toujours en cours d'exécution d'une instance de DataNode (qui permet HDFS pour stocker et récupérer des blocs de données sur le nœud esclave) et une instance TaskTracker (qui permet l'JobTracker attribuer carte et réduire les tâches au noeud esclave pour le traitement) .

Nœuds esclaves ont un nombre fixe de carte fentes et de réduire les fentes pour l'exécution du plan et de limiter les tâches respectivement. Si votre cluster fonctionne HBase, un certain nombre de vos nœuds esclaves devra lancer un service de RegionServer. Le plus de données que vous stockez dans HBase, les cas plus de RegionServer vous aurez besoin.

Les critères de matériels pour les nœuds esclaves sont assez différentes de celles pour le maître nodes- en fait, les critères ne correspondent pas à ceux trouvés dans les architectures de référence du matériel traditionnels pour les serveurs de données. Une grande partie du buzz autour de Hadoop est due à l'utilisation de matériel de base dans les critères de conception des clusters Hadoop, mais gardez à l'esprit que marchandise le matériel ne fait pas référence à du matériel de consommation de qualité.

Nœuds esclaves Hadoop nécessitent encore du matériel de classe entreprise, mais à l'extrémité inférieure du spectre des coûts, en particulier pour le stockage.