Comment détecter et prévenir les hacks de traversée de répertoire

Traversée de répertoire est une faiblesse très basique, mais il peut tourner jusqu'à intéressante - des informations sur un système Web, le rend vulnérable aux hacks - parfois sensibles. Cette attaque consiste parcourant un site et recherche d'indices sur la structure de répertoires du serveur et des fichiers sensibles qui pourraient avoir été chargés, intentionnellement ou non.

Effectuez les tests suivants pour déterminer des informations sur la structure des répertoires de votre site web.

Crawlers

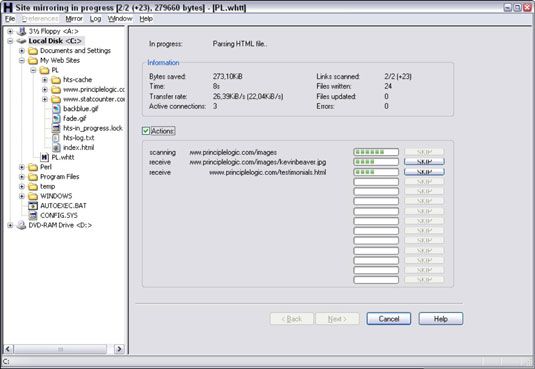

Un programme d'araignée, comme le site Web de HTTrack gratuitement Copieur, peut explorer votre site à la recherche de tous les fichiers accessibles au public. Pour utiliser HTTrack, simplement charger, lui donner un nom au projet, dites HTTrack quel site (s) au miroir, et après quelques minutes, peut-être des heures, vous aurez tout ce qui est accessible au public sur le site stockée sur votre disque local dans c: Mes sites.

Les sites complexes révèlent souvent plus d'informations qui ne devraient pas être là, y compris les anciens fichiers de données et même des scripts d'application et le code source.

Inévitablement, lors de l'exécution des évaluations de sécurité web, il ya généralement .fermeture éclair ou .rar fichiers sur les serveurs web. Parfois, ils contiennent ordure, mais souvent ils détiennent des informations sensibles qui ne devraient pas être là pour le public d'accéder.

Regardez la sortie de votre programme de ramper pour voir quels fichiers sont disponibles. Fichiers HTML et PDF régulières sont probablement correct parce qu'ils sont plus susceptibles nécessaires pour l'utilisation du web normale. Mais il ne serait pas mal d'ouvrir chaque fichier pour vérifier qu'il appartient là et ne contient pas d'informations sensibles que vous ne voulez pas partager avec le monde.

Google peut également être utilisé pour une traversée de répertoire. En fait, les requêtes avancées de Google sont si puissants que vous pouvez les utiliser pour extirper des informations sensibles, les fichiers et les répertoires du serveur Web critiques, numéros de cartes de crédit, les webcams - fondamentalement quelque chose que Google a découvert sur votre site - sans avoir à refléter votre site et passer au crible tout manuellement. Il est déjà assis là dans le cache de Google en attente d'être vu.

Ce qui suit est un couple de requêtes avancées de Google que vous pouvez entrer directement dans le champ de recherche Google:

Mots-clés de nom d'hôte: le site - Cette requête recherche d'un mot clé vous énumérez, comme SSN, confidentiel, carte de crédit, et ainsi de suite. Un exemple serait:

Site: principlelogic.com haut-parleur

filetype: Site extension de fichier: nom d'hôte - Cette requête recherche des types de fichiers spécifiques sur un site web spécifique, comme doc, pdf, db, DBF, fermeture éclair, et plus. Ces types de fichiers peuvent contenir des informations sensibles. Un exemple serait:

filetype: pdf Site: principlelogic.com

D'autres opérateurs Google avancés sont les suivants:

allintitle recherche de mots clés dans le titre d'une page Web.

inurl recherche de mots clés dans l'URL d'une page web.

connexe Trouve les pages similaires à cette page web.

lien montre d'autres sites qui pointent vers cette page web.

Une excellente ressource pour Google hacking est Google Hacking base de données de Johnny long.

Lorsque tamisage à travers votre site avec Google, assurez-vous de chercher des informations sensibles sur vos serveurs, réseau, et l'organisation de Google Groupes, qui est l'archive Usenet. Si vous trouvez quelque chose qui n'a pas besoin d'être là, vous pouvez travailler avec Google pour avoir édité ou enlevé. Pour plus d'informations, reportez-vous à Google de page Contactez-nous.

Mesures contre traversées de répertoires

Vous pouvez employer des trois principales contre-mesures contre les fichiers ayant compromis via malveillants traversées de répertoires:

Ne pas stocker les fichiers anciens, sensibles, ou autrement non publiques sur votre serveur web. Les seuls fichiers qui doivent être dans votre / htdocs ou DocumentRoot dossier sont ceux qui sont nécessaires pour que le site fonctionne correctement. Ces fichiers ne doivent pas contenir des informations confidentielles que vous ne voulez pas le monde à voir.

Configurez votre robots.txt fichier pour empêcher les moteurs de recherche, tels que Google, de ramper les zones les plus sensibles de votre site.

Assurez-vous que votre serveur Web est correctement configuré pour permettre l'accès du public aux seuls répertoires qui sont nécessaires pour que le site fonctionne. Privilèges minimums sont la clé ici, donc donnent accès à uniquement les fichiers et les répertoires nécessaires à l'application Web pour fonctionner correctement.

Consultez la documentation de votre serveur Web pour obtenir des instructions sur le contrôle de l'accès du public. Selon la version de votre serveur Web, ces contrôles d'accès sont mis en

La httpd.conf fichier et le .htaccess fichiers pour Apache.

Internet Information Services Manager pour IIS

Les dernières versions de ces serveurs Web ont une bonne sécurité de répertoire par défaut donc, si possible, assurez-vous que vous utilisez les dernières versions.

Enfin, pensez à utiliser un pot de miel de moteur de recherche, tels que Google Hack Honeypot. Un pot de miel attire des utilisateurs malveillants afin que vous puissiez voir comment les méchants travaillent contre votre site. Ensuite, vous pouvez utiliser les connaissances acquises pour les tenir à distance.