Courir workflows oozie dans Hadoop

Avant d'exécuter vos flux de oozie, toutes ses composantes doivent exister au sein d'une structure de répertoire spécifié. Plus précisément, le flux de travail lui-même devrait avoir son propre répertoire dédié, où workflow.xml est dans le répertoire racine, et les bibliothèques de code existe dans le sous-répertoire nommé lib. Le répertoire de flux de travail et tous ses fichiers doivent exister dans HDFS pour qu'il soit exécuté.

Si vous utilisez l'interface de ligne de commande oozie de travailler avec divers emplois, veillez à définir la variable d'environnement de OOZIE_URL. (Cela se fait facilement à partir d'une ligne de commande dans un terminal Linux.) Vous pouvez vous épargner beaucoup de dactylographie parce que l'URL du serveur oozie sera maintenant automatiquement inclus avec vos demandes.

Voici un exemple de commande, on pourrait utiliser pour définir la variable à partir de la ligne de commande de l'environnement de OOZIE_URL:

l'exportation OOZIE_URL = "http: // localhost: 8080 / oozie"

Pour exécuter une charge de travail de oozie partir de l'interface de ligne de commande oozie, exécutez une commande comme celle-ci, tout en assurant que le fichier est job.properties accessible localement - qui signifie que le compte que vous utilisez peut le voir, ce qui signifie qu'il doit être sur le même système où tu fuis oozie commandes:

$ Job de oozie -config sampleWorkload / job.properties -run

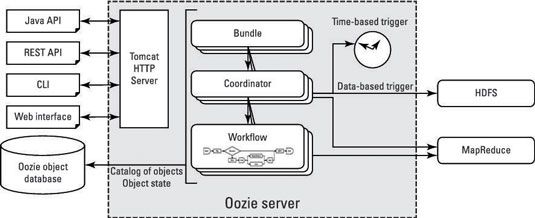

Après vous soumettez un travail, la charge de travail est stocké dans la base de données objet oozie.

Lors de la présentation, oozie retourne un identifiant pour vous permettre de surveiller et d'administrer votre flux de travail - emploi: 0000001-00000001234567-oozie-W, par exemple.

Pour vérifier l'état de ce travail, vous souhaitez exécuter la commande

travail de oozie -info 0000001-00000001234567-oozie-W